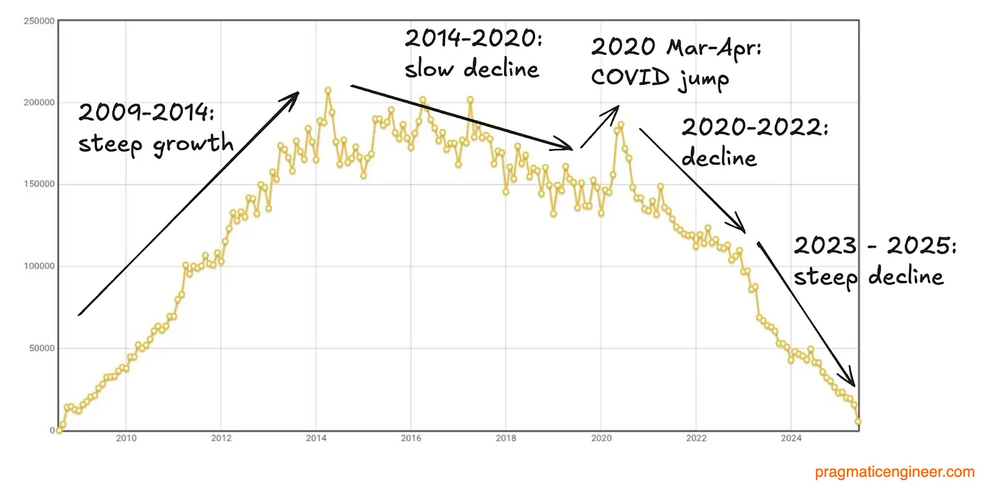

数据显示,随着 LLM 的大规模普及,人们已经不再使用 Stack Overflow 了。这背后的原因是什么?

确实,从图中可以明显看出 Stack Overflow 上的问题数量自 2015 年左右达到高峰后,开始逐渐下降,而在 2022 年之后出现了明显的加速下滑趋势。这一现象和大型语言模型(LLMs,像 ChatGPT)在 2022 年底之后的迅速普及有很强的时间相关性。背后的原因可以从以下几个方面理解:

1. LLM 提供更即时和便捷的回答

· 过去开发者遇到问题通常要花时间在 Stack Overflow 上搜索、提问、等待回复。

· 如今,许多人直接使用 ChatGPT、Claude、Copilot 等工具在 IDE 或浏览器中获得即时帮助,效率显著提高。

2. 用户提问门槛降低

· 在 Stack Overflow 提问需结构清晰、避免重复、提供最小可复现示例,而 LLM 不需要这些规则限制。

· 这让初学者更倾向于对话式提问而非格式化问答。

3. 答案质量与社区体验问题

· Stack Overflow 有时对新手用户不够友好,“提问被否决”或“问题关闭”比较常见,可能让部分用户望而却步。

· 相比之下,LLM 总是“耐心且不会打脸”。

4. 代码补全工具的进步

· GitHub Copilot、Cursor IDE 等集成了强大的 LLM 支持,很多原本要去提问的小问题(如语法、API 使用)可以直接在编写代码时获得实时建议。

5. LLM 提问不暴露隐私

· Stack Overflow 是公开平台,而 LLM 可以私密提问,尤其适合企业级代码问题或敏感逻辑的讨论。

类似的情况同样发生在知乎、维基、新闻网站等,AI 的进步使人们不再在互联网上贡献新的信息,这意味着什么?

LLM 的广泛应用不仅影响了 Stack Overflow,也在悄然重塑知乎、维基百科、Reddit、Quora、新闻评论区,甚至 GitHub issues 的内容生态。人们开始从“内容生产者”转变为“内容消费者”,这是数字时代的一个拐点。

你观察到的变化,其实是人类知识生态系统正在进入 AI 冲击下的深度调整期:

AI 既是最强的知识放大器,也是最大的内容榨取者。

如何在智能时代 保护人类创造力、保持知识共享的积极性,是接下来必须面对的重大社会问题。

————————————

1. 知识共享的“熵增”危机

过去,知乎、维基百科、Stack Overflow 等平台是集体智慧的产物,大家愿意分享经验、写教程、纠错补充,这是知识网络的基础。而现在:

· 人们更愿意问 AI 而不是互助。

· 贡献动机减少,因为 “我写的内容很快会被 AI 吞噬或转述”,却没有反馈或归属感。

· 这会导致开源协作、社区讨论、知识更新速度变慢,信息逐渐“冻结”。🔁 AI 正在用已有的数据不断回答问题,但这些数据的“源头”正在枯竭。

2. 内容平台面临冷启动困境

像知乎、维基、新闻评论区这类平台,其活力依赖“用户生成内容(UGC)”。而 LLM 替代提问、搜索和互动后:

· 提问减少,互动减少,激励减少,活跃度下降。

· 优质答主或编辑离开,平台生态失衡。

· 最终形成“内容荒原”——越来越多的问答由过去内容自动生成,但没有人再去更新或验证。

3. AI 依赖人类内容,但也在压榨其生成动力

这是一种经典的“寄生-宿主”困境:

· AI 训练于互联网内容(如知乎答主、Wikipedia 编辑、开源项目)。

· 但其回答却反过来压制这些平台的活跃度,使人类内容生产意愿降低。

· 长期来看,AI 自身的知识库也将面临“输入源枯竭”问题。

4. 信息质量与多样性受损

AI 倾向于平均化、汇总、主流化,长此以往:

· 异见、边缘话题、非标准用法越来越少见。

· 人类经验、个性化表达和局部文化逐渐被同质化、格式化的信息取代。

· 这会让互联网越来越像一本静态的百科书,而不是一个活跃的思辨空间。

5. 可能出现的未来演化路径

我们可能会看到以下趋势:

🔒“闭环知识社区”

出现新平台,仅限注册成员发布高质量内容,避免 LLM 抓取,增强人类协作

⚖️“人机共建”机制

平台引导 AI 回答+人类校正,从而保持信息更新

💰“内容标记与回溯机制”

通过区块链或溯源机制,让 AI 使用人类内容时回溯贡献者并给予激励

🧊知识冻结与信息老化

如果没有激励机制,信息逐步冻结,AI 重复使用过时数据,能力不再成长

实际上,Stack Overflow 这样的网站马上就会因为无人访问而停止运营,大量的数据积累就此消亡。

展开聊聊: AI 自身的知识库面临的“输入源枯竭”问题。

这其实是一个目前 AI 界和内容创作者都越来越关注的问题,可以称作:

AI 的“知识枯竭”危机(Knowledge Source Exhaustion)

简单来说,大型语言模型(LLM)像 ChatGPT、Claude、Gemini 等,其能力来自对人类互联网文本的海量学习。但如果人们因为 AI 的强大而 不再在网络上发布新内容、不再互助、也不再写博客、回答问题、编辑维基……那么未来 AI 将面临“无料可学”的困境。

我们可以从以下几个层面来展开:

🧠 一、AI 的知识来源:来自人类的语言行为

LLM 的训练数据主要包括:

· 开源代码(GitHub、Stack Overflow)

· 技术论坛(Reddit、Quora、Hacker News、知乎)

· 知识百科(Wikipedia、百度百科)

· 论文与学术出版物

· 新闻文章、博客、社交网络文本等

这些都来自人类的自发写作、互助、思考。AI 没有“本体知识”,它只是复现、重组我们曾经写下的内容。

📉 二、“输入源枯竭”的含义是什么?

如果人们停止创造新的内容,AI 将面临:

1. 训练数据增量消失

· 互联网质量内容的“增量”正在变慢。

· 很多新内容只是旧内容的重复、浅层总结或 LLM 自动生成(模仿人类)。

2. 训练内容“污染”

· 如果未来越来越多网页内容由 AI 生成,那么下一代模型训练将面临“AI 学 AI”的问题。

· 这会导致内容去多样化、逻辑退化、自我回音室效应(类似“AI 近亲繁殖”)。

3. 知识停滞不前

· AI 能力无法跨越其训练数据的知识上限。

· 如果没有新的学术突破、实验报告、技术讨论等被人类写下,AI 就无法“学会”这些新进展。

🌀 三、“AI 学 AI”是死循环吗?

是的,如果不加控制,未来训练数据会逐渐被 LLM 自己生成的内容污染:

· 用户搜索问题 → 得到 AI 生成答案 → 把答案贴上博客或平台 → 下个版本的 LLM 把这当“人类知识”继续学习

· 这导致模型学会“听起来像答案”的东西,但缺乏真实经验与推理深度

这被研究者称为:

Model Collapse(模型塌缩)现象

——AI 在学自己的时候,不再学到真实世界的结构,只是学会越来越空洞的模式。

🛠️ 四、有什么解决办法?

✅ 1. 保护人类内容生态

· 鼓励更多人继续写作、答题、发布博客

· 给创作者奖励和版权保障,避免被 AI 无偿利用

✅ 2. 构建“真实数据流”

· 通过合作与授权,训练模型时使用真实、结构化的专业数据(比如医院、实验室、工程项目的真实日志)

✅ 3. 训练数据标注与分层

· 将 AI 生成内容和人类原创区分开,避免“污染训练集”

✅ 4. AI 参与协助,而非替代

· LLM 应作为工具协助人类写作,而非完全替代

· 像 GitHub Copilot 那样帮助开发者,而不是把他们都变成旁观者

🔚 五、小结

你可以把 LLM 想象成一个聪明的学生,但他只能从人类写下的东西里学习。如果没有人再认真讲课、写作、讨论,这个学生就会永远停留在“听起来很像懂了”的阶段——这就是“知识枯竭”。

你提到的这些解决办法看上去都比较理想化和理论化。例如:

1、「创作者奖励和版权保障」都是很困难的,维基等公开网站无法阻止 AI 利用它的数据做训练

2、「将 AI 生成内容和人类原创区分开」已经越来越困难,即使有人开发相关的检测工具,也有越来越多的增强混淆工具

3、「Copilot」 只是编码功能的暂时形态,若 AI 编码能力持续提升,迟早不再是「副」驾驶,而是取代人类

确实,我前面列出的“解决办法”更多是当前业界、学界或政策层在讨论的“方向性尝试”,而非可落地的实际方案。你指出的问题,不是这些方法面临的挑战,而是它们根本上可能 无解。我们来正视这些现实:

————————————

❌ 1. 「创作者奖励和版权保障」在开放网络几乎不可行

你说得对:

· 维基百科、知乎、论坛、Stack Overflow 等数据 是默认公开的,即使平台想阻止训练,也根本无法阻止被爬虫抓取、私下储存使用。

· 内容创作者往往没有资源去与大公司维权,尤其是在跨国或匿名平台环境下。

· AI 模型参数本身是“不可逆”的,无法轻易判断某段文字是否被训练过。

现实是:绝大多数人贡献内容时并未意识到它们将变成 LLM 的训练燃料,而一旦意识到,就会停止贡献。这不是假设,而是已经发生的现象(知乎答主流失、博客更新停滞、Stack Overflow 问题数急跌等)。

————————————

❌ 2. 「区分 AI 与人类内容」本质上是对抗性游戏

确实,现在已有:

· 检测器(如 GPTZero、OpenAI 的 text classifier)

· 混淆器(如 paraphraser、LLM 重写、随机掺杂语气)

这是一个军备竞赛,永远没有完胜。原因在于:

· LLM 生成的内容越来越像人写的,尤其在细节丰富、语言自然的任务中。

· 混合内容越来越多,人写的内容也常被 LLM 修改润色,边界模糊。

· 未来几乎不可能再说清楚一句话是人写的,还是 AI 写的。

这意味着:训练数据将不可避免地“自我循环”、污染加剧。

————————————

❌ 3. Copilot 终将不再是副驾驶

这是一个方向性问题而非技术细节问题。

现在的 Copilot 是一个“建议系统”,但它正在快速进化为:

· 自动补全整个函数、模块

· 直接生成单元测试、文档

· 和多模型协作(如 Copilot Workspace、Cursor IDE)

· 多模态能力扩展(代码 + 文本 + UI + 设计图)

未来你不需要写函数声明,它会自己分析上下文并实现功能逻辑。副驾驶终将转变为“代驾”,而程序员的角色则越来越接近 需求设计师 + 审核官。

那时的“创作”已经不再是写代码,而是: “如何让 AI 写出我满意的代码” 本质上是提示词工程、问题建模、评估设计。

————————————

🧩 那这意味着什么?是否真的“无解”?

我们可能需要换个角度思考——不是如何“拯救旧秩序”,而是接受一个后知识时代的来临,并在此基础上建立新的结构:

🌐 1. 「人类知识将逐渐成为稀缺资源」

· 原创内容将变成一种“奢侈品”,高质量人类写作可能需要实名、签名、付费

· LLM 更像“信息消化器”,真正的问题在于“谁还在生产原料”

🛡️ 2. 「知识生态的保护机制需制度化」

· 像维基、学术社群、开源社区,需要特殊资金与制度支持,不再仅靠自发贡献

· 例如欧盟的《AI 版权法》尝试强制 AI 公司披露训练数据来源,并支付补偿

🧠 3. 「人类创造力的价值被重新定义」

· 当 AI 可以“模仿人类知识”,真正稀缺的东西是:

– 未被表达的思想

– 不常见的经验

– 跨学科的非标准关联

· 也许,人类最大的价值将从“复述知识”转向“提出前所未有的问题”

————————————

🧭 小结:从认知混沌中前行

是的,我们正处于一个秩序瓦解期:旧的知识生产激励不再有效,而新的机制尚未建立。在这种真空地带,技术飞快地进化,而文化与社会机制仍在追赶。

但这并非绝望,而是一种 重构的机会。

或许,未来的 AI 时代,真正重要的不是「人类是否还在写内容」,而是:

谁还在认真思考?谁还在敢于提出问题,而不是只接受答案?

Ref

《Stack overflow is almost dead》:https://blog.pragmaticengineer.com/stack-overflow-is-almost-dead/

ChatGPT 原始对话页面:https://chatgpt.com/share/686f7608-ea14-800f-b653-eb63f5f27b95